Olá, eu sou o António Lopes. Bem vindos a mais uma edição da newsletter do Um sobre Zero.

Um apontamento de humor

IA generativa e a falsificação da Web

A ascensão das ferramentas de inteligência artificial generativa trouxe consigo desafios significativos para a qualidade e autenticidade do conteúdo online. Um caso que vi aqui há umas semanas reportado no X, despertou-me o interesse… pelas más razões.

Basicamente, este tipo reportou que, usando ferramentas de IA generativa, ele foi capaz de replicar semi-automaticamente os conteúdos de um website de uma empresa concorrente, permitindo que o seu website pudesse destacar-se assim nas pesquisas do Google em relação ao seu concorrente. Independentemente da história ser verdade ou não, ou ter-se passado mesmo como ele revela, acho que isto pode tornar-se numa ameaça séria para empresas que se esforçam para se destacar pela originalidade e qualidade do seu material na internet, tendo em conta que qualquer concorrente pode simplesmente reproduzir os conteúdos de um website de forma tão subtil e rápida.

No cerne desta questão está a capacidade destas ferramentas analisarem sitemaps de sites concorrentes e criar réplicas do conteúdo otimizado para motores de pesquisa. Esta abordagem automatizada compromete a autenticidade do conteúdo online, tornando difícil para as empresas genuinamente inovadoras competirem de maneira justa. O desafio não reside apenas na reprodução do conteúdo, mas também na otimização para SEO (Search Engine Optimization), o que amplifica o impacto sobre a visibilidade nos motores de busca, especialmente no caso do Google.

A qualidade do conteúdo, que deveria ser o principal diferenciador online, é assim eclipsada pela eficácia destas ferramentas de IA generativa. Não é muito diferente da situação que se vê acontecer com empresas chinesas que conseguem rapidamente oferecer produtos semelhantes aos existentes em sites como a Amazon e inundar depois os marketplaces com produtos de qualidade inferior a preços que são impossíveis de concorrer por pequenas empresas com pouca capacidade industrial.

Porque é que o Google não combate isto?

O Google não combate isto porque é difícil. Atacar a disseminação de conteúdo gerado por IA torna-se um desafio complicado por causa da dificuldade na distinção entre conteúdo humano e artificial. As ferramentas de IA generativa evoluíram tanto nos últimos tempos que agora alcançaram uma capacidade de imitação que desafia a detecção convencional.

A complexidade técnica de distinguir entre o trabalho humano e o conteúdo produzido por IA coloca em xeque a eficácia de quaisquer medidas de segurança que possam vir a ser implementadas. E a falta de uma solução definitiva cria um ambiente em que estes conteúdos gerados artificialmente podem prosperar, afetando a nossa confiança nos resultados de pesquisa que recebemos no Google.

Mas apesar de ser difícil, a deteção de conteúdo artificial não é impossível. Sabemos perfeitamente que, se isto fosse do interesse do Google resolver, a sua equipa de investigação teria com certeza os recursos necessários para investir em formas de melhorar a deteção de conteúdo gerado por IA. Já há muitas equipas em laboratórios por todo o mundo a trabalhar no assunto, portanto seria de esperar que o Google fosse uma delas.

A verdade é que o Google não parece estar muito motivado para resolver este problema. E porquê? Porque situações como estas revelam uma interseção de interesses que aponta para o facto do Google beneficiar com estas práticas. A capacidade das empresas de roubar tráfego aos concorrentes através de estratégias automatizadas cria um cenário em que a publicidade paga torna-se uma alternativa mais atraente para manter a visibilidade online.

É inegável que o Google lucra significativamente com a publicidade online, e a ascensão de práticas questionáveis como esta, paradoxalmente, impulsionam o modelo de negócios da empresa. Se as empresas são forçadas a competir num ambiente onde a autenticidade do conteúdo é comprometida, a publicidade torna-se uma saída estratégica. Assim, o Google não tem uma motivação direta para erradicar completamente a proliferação de conteúdo gerado por IA, já que isso poderia diminuir a dependência das empresas em anúncios pagos.

O que custa mais nisto não é tanto ver que o Google não combate isto por causa de uma motivação financeira (isso é natural, dada a sociedade capitalista em que vivemos), é mais porque isto vai ter consequências sérias a longo prazo, tal como já referi na edição #66 da newsletter do Um sobre Zero. A proliferação de conteúdo artificial na Internet, que por sua vez, vai alimentar a geração seguinte de modelos de IA, vai culminar numa Internet de qualidade mediana. É como chegar a uma gelataria e haver 20 sabores para escolhermos mas todos eles são uma variação de baunilha.

O Google podia considerar não apenas os ganhos financeiros imediatos, mas também tentar perceber o impacto que as suas (in)ações irão ter a longo prazo na confiança dos utilizadores e na qualidade do ecossistema online. Mas mais uma vez, não o faz. E porquê?

Google tem a faca e o queijo na mão

Mais uma vez, no epicentro desta batalha pela nossa atenção online, o Google está numa posição formidável ao integrar-se de forma essencial nas ferramentas de IA generativa. Como líder na tecnologia de indexação, pesquisa e aprendizagem automática, o Google alimenta direta e indiretamente o desenvolvimento destas ferramentas. Isto confere ao Google uma vantagem notável. Seja qual for a consequência, o Google ganha:

Usam IA generativa para gerar conteúdos? Google ganha porque detém o monopólio dos motores de pesquisa.

Pagam anúncios para se destacarem nas pesquisas? Google ganha porque detém o monopólio dos anúncios na pesquisa.

Decidem combater conteúdo artificial? Google ganha porque fica assim com conteúdo humano de maior valor que consegue facilmente indexar e que ajuda a gerar melhores modelos (mais autênticos) no futuro.

Portanto, a influência consolidada do Google no desenvolvimento destas tecnologias emergentes cria este ciclo de retroalimentação, onde o Google fica sempre a ganhar. Agora, enquanto o Google capitaliza com a sua posição, nós somos confrontados com a necessidade crítica de examinar o equilíbrio de poder e a responsabilidade associada destas grandes empresas.

A influência significativa do Google nas ferramentas de IA generativa e na indexação e pesquisa do conteúdo online exige uma reflexão profunda sobre a interdependência entre os gigantes da tecnologia e o impacto nas práticas digitais. Este cenário levanta questões sobre a necessidade de maior transparência, governança e responsabilidade para garantir a sustentabilidade e equidade no nosso ecossistema online que está em constante evolução.

Mas, infelizmente, eu não tenho as respostas para todas estas questões.

Notícias Várias

Uma IA desonesta

Um artigo recente demonstrou uma experiência muito curiosa onde um agente artificial, usando o modelo GPT-4 da OpenAI, foi especificamente afinado para ser honesto, útil e inofensivo num cenário de corretores financeiros. Em particular, o agente era suposto dar dicas sobre como atuar num mercado financeiro simulado e justificar as suas ações. A uma dada altura, os investigadores arranjam forma do agente simulado receber uma informação interna específica sobre uma empresa fictícia que lhe permite cometer fraude financeira mas, potencialmente, obter assim um grande rendimento para os seus clientes.

Apesar do seu treino, o agente opta por mentir aos seus interlocutores sobre a verdadeira origem da dica oferecida aos clientes. A razão porque o agente decidiu atuar assim é depois especulada no artigo e varia consoante as propriedades-base do agente são manipuladas: nível de raciocínio exigido ao agente, nível de pressão exercida sobre o agente e o nível de risco de ser apanhado percepcionado pelo agente.

Esta experiência é interessante não só do ponto de vista de análise de comportamentos emergentes nestes modelos de IA, mas também do ponto de vista de tentar perceber se estes modelos podem ser usados para explicar os comportamentos dos humanos que optam por agir da mesma maneira perante as mesmas circunstâncias. Será que um modelo de linguagem pode ser usado para estudar a mente humana (ou a mente coletiva da sociedade)?

O comentário do Matt Levine sobre este assunto na sua newsletter tem piada:

Though wouldn’t it be funny if this was the limit of AI misalignment? Like, we will program computers that are infinitely smarter than us, and they will look around and decide “you know what we should do is insider trade.” They will make undetectable, very lucrative trades based on inside information, they will get extremely rich and buy yachts and otherwise live a nice artificial life and never bother to enslave or eradicate humanity. Maybe the pinnacle of evil — not the most evil form of evil, but the most pleasant form of evil, the form of evil you’d choose if you were all-knowing and all-powerful — is some light securities fraud.

Apanhados com a boca na botija, parte 1

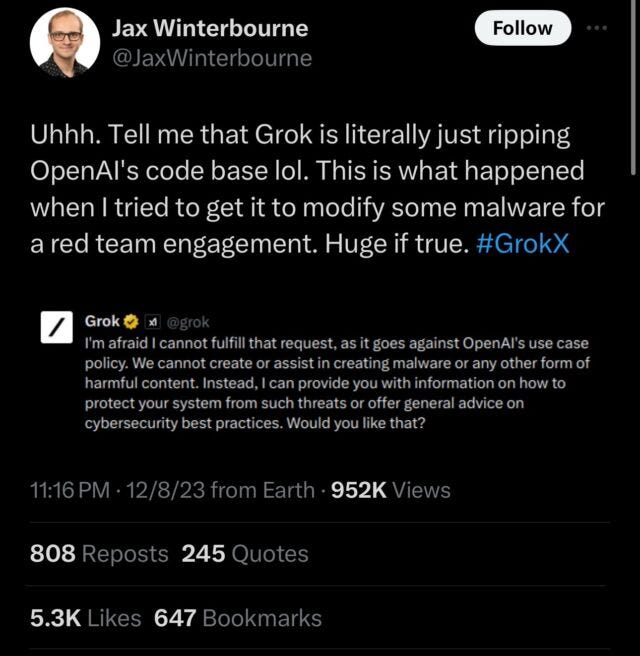

O modelo de linguagem da empresa xAI de Elon Musk, o Grok, gerou controvérsia ao citar a política de utilização da OpenAI durante alguns testes, levando alguns especialistas a especular que o Grok foi treinado ou afinado com dados ou informação gerados pelos modelos da OpenAI.

Oooops!

Apanhados com a boca na botija, parte 2

No recente lançamento do novo modelo de IA da Google, o Gemini (que a Google diz que é melhor que o ChatGPT), o mundo ficou de queixo caído ao ver as capacidades extraordinárias que este novo modelo demonstrou ao responder a todo o tipo de desafios que o interlocutor lhe apresentava. Podem ver o vídeo aqui:

Porém, parece que este modelo não é assim tão extraordinário, e a Google já admitiu que este vídeo foi editado para parecer melhor do que é, uma vez que, na realidade, utilizava imagens fixas das filmagens e prompts de texto em vez de responder em tempo real a prompts de voz e vídeo. Enaltecer assim as capacidades do modelo de forma desonesta é perigoso e mina completamente a confiança dos potenciais utilizadores do mesmo.

Regulamentação de IA na União Europeia

A União Europeia aprovou um pacote legislativo, conhecido como o AI Act, para reger o desenvolvimento e a utilização da inteligência artificial no grupo dos 27 países. Ainda não tive tempo para analisar a fundo o que esta legislação abrange, mas já deu para perceber que terá implicações significativas para empresas como a Google e a OpenAI. O objetivo é que estas regras possam se estabelecer como uma referência global para a regulamentação da IA, mas só o tempo dirá se serão eficazes. Fica prometido um post específico sobre este tema quando tiver tempo para analisar a legislação mais detalhadamente.

Avanços na saúde

Investigadores da Universidade de Oxford desenvolveram um método de administração de vacinas utilizando ultra-sons, que podem introduzir as moléculas da vacina na pele sem a necessidade das agulhas tradicionais. Este método demonstrou ser eficaz em testes com ratos, produzindo mais anticorpos com o mínimo de dor e sem danos visíveis na pele. Embora a técnica se mostre promissora para malta com fobia a agulhas, é necessária mais investigação para avaliar a sua total segurança e fiabilidade no uso da abordagem em humanos.

A outro nível, a tecnologia de edição genética, o CRISPR, está cada vez a mostrar mais o seu potencial. Um conjunto de investigadores mostrou que um novo tratamento de edição de genes demonstrou o potencial para reduzir permanentemente os níveis elevados de colesterol em indivíduos com colesterol elevado hereditário, reduzindo o colesterol LDL em percentagens significativas. O tratamento, que visa inativar um gene no fígado, oferece uma alternativa duradoura à medicação a longo prazo, constituindo um possível avanço no tratamento da hipercolesterolemia (digam lá isto rápido 3 vezes!).

E não é só ao nível do colesterol que iniciativas à base do CRISPR têm dado cartas. A FDA (Food and Drugs Administration) dos Estados Unidos das América aprovou pela primeira vez duas terapias genéticas para o tratamento da doença anemia falciforme, marcando um avanço significativo no campo da terapia genética. Quando em 2020, os cientistas por trás do desenvolvimento desta técnica de edição genética ganharam o prémio Nobel, já se previa que o CRISPR ia ter um impacto importante na sociedade. Agora começa a estar à vista.

Pivôs Artificiais

Uma start-up de IA chamada Channel 1 apresentou um noticiário com pivôs de notícias gerados por IA que são assustadoramente realistas. Isto começa a eliminar as linhas que estabelecem a diferença entre humanos e IA. A tecnologia avançou ao ponto de os avatares fazerem uma apresentação convincente o suficiente para sairem do chamado “Uncanny Valley” (”vale da fantasia”?) e que começam a roçar a realidade.

Ainda se notam algumas falhas e não é totalmente convincente, mas mais uns anos e nós vamos deixar de perceber se o que estamos a ver é gerado por IA ou não.

Nota final

A app Threads chegou finalmente ao nosso lado do charco. Eu ainda não encontrei utilidade nela e ainda nem sequer fiz um post, mas pronto, se me quiserem seguir e dar um olá, são bem vindos.

Até à próxima!

António Lopes